|

Science ou politique ?

Le réchauffement global du climatRien qu'une bulle d'air chaud ?Dossier réalisé par Augustin Vidovic.Vous pouvez réagir à ce dossier dans son forum en ligne associé |

Acte 1 : Y'a plus d'saisons, ma bonne dame !

Il y a une quarantaine d'années, deux décennies de climat un peu frais avaient suscité l'inquiétude des agriculteurs, puis du reste du monde. Les 26 et 27 décembre 1968, à Dallas, a lieu le symposium de L'Association Americaine pour l'Avancement des Sciences (AAAS) intitulé "Les effets globaux de la pollution de l'environnement". La pollution fait un coupable tout trouvé pour les malheurs du temps, d'une part parce que personne n'aime la pollution, et d'autre part parce que la contre-culture, qui prend son essort à son époque, accompagne un sentiment de rejet de la civilisation technique. On s'y intéresse aux effets à grande échelle possibles sur l'atmosphère, que ce soit par l'injection d'aérosols qui augmenteraient l'albedo, la production de CO2 ou autres gaz qui pourraient causer un effet de serre, ou causer l'amincissement de la couche à ozone (une couche de la stratosphère ayant une concentration de moins d'une dizaine de molécules de O3 pour un million de molécules d'autres gaz de l'air, dont l'épaisseur, ramenée à la pression du sol, varie entre 2 et 5 millimètres selon la latitude, l'époque de l'année, et l'activité solaire).

Manque de bol, à partir de la fin des années 1970, les étés ne sont plus si froids (on se souvient de la canicule de 1976, entre autres), et au début des années 1980, on oublie naturellement cette affaire de refroidissement...

Acte 2 : Une histoire pleine de trous

Prenant le relais dans le rôle d'épouvantail global, le discours annnonçant la disparition prochaine de la couche à ozone se développe durant les années 1980. Le thème central se base sur les effets (connus) des UVB d'une part, et les spéculations sur l'éventuelle diminution du rôle filtrant des UVB solaires de l'ozone stratosphèrique d'autre part (cancers de la peau, extermination du plancton, perte des récoltes, etc, les sept plaies de l'Egypte, en somme).Un coup d'essai sur ce thème avait été réussi en 1971, lorsque le programme de développement des avions supersoniques américains (SST) avait été stoppé net par le Congrès US à cause d'inquiétudes sur les ravages possibles dûs au "bang" supersonique, pour ne plus être réactivé, suite au rapport de Harold Johnston, qui estimait que les rejets de NOx dans la stratosphère par les avions pouvait endommager cette couche à ozone.

Il y a plusieurs théories sur ce qui pourrait causer un éventuel amincissement de la couche à ozone, en plus de celle de Johnston. Il y a aussi celle de la vapeur d'eau rejetée par les tuyères des avions stratosphériques (James McDonald, 1971), des rejets de méthane par les élevages bovins (Singer, 1971), celle des rejets de Chlore provenant ou non des CFC (Cicerone et Stolarski en 1973, Rowland et Molina en 1974).

Le mouvement hippie s'est effiloché, mais le mouvement de l'écologie politique (Greenpeace, etc) a alors pris le relais de la haine de la civilisation technologique. James Lovelock, prêtre de la religion de Gaïa, a construit en 1970 un appareil très précis permettant de mesurer les concentrations en ppm de CFC dans l'atmosphère et s'en sert pour constater la présence de CFC dans l'air jusqu'en Antarctique, sur son navire. Ses résultats ont convaincu Rowland que sa théorie était fondée. En 1978, les écologistes ont réussi à faire interdire les CFC comme gaz propulsants dans les bombes aérosols aux USA.

En 1985, Joseph Farman, du British Antarctic Survey, va comme par hasard "découvrir" un "trou" (en fait une réduction de la concentration en O3) dans la couche à Ozone au-dessus de l'Antarctique. "Découvrir" est un grand mot, vu que ce phénomène saisonnier dû au vortex antarctique est observé depuis 1956 (Dobson à Halley Bay en 1956 et 1957, puis base française de Dumont d'Urville en 1958, cette année-la plus proche du centre du vortex). Si on disposait de mesures datant d'avant 1956, il est fort probable que l'on y constaterait aussi ce phénomène, chaque année entre octobre et novembre.

La théorie de Rowland sur les CFC ne prévoyait absolument pas cela, mais la machine médiatique se met en branle et la nouvelle catastrophe à la mode est annoncée : des principales théories en présence, on n'accuse, ni le méthane, ni la vapeur d'eau (car ils existent à l'état naturel), mais le seul composé provenant de l'industrie humaine, les CFC, qui seraient responsables d'une destruction sans précédent d'un élément essentiel à la vie sur Terre.

En 1986, l'état-major de l'entreprise de chimie Du Pont décide de participer à la campagne anti-CFC. L'interdiction des CFC lui permettrait de réaliser d'énormes profits avec le marché des produits de remplacement, beaucoup plus chers et moins efficaces, d'autant qu'on estime que les pays comme la Chine vont fabriquer en masse des appareils de réfrigération.

En 1987, le protocole de Montréal faisant des CFC une substance contrôlée est signé. Autrement dit, les CFC feront désormais l'objet d'un marché de prohibition, ce qui les rendra ipso facto beaucoup plus chers. Le protocole sera révisé et aggravé à Londres en 1990, et 59 nations (peut-être encouragées par l'article 4) donnent leur accord pour une interdiction de la production des CFC en 2000. Ce n'est pas assez rapide, semble-t-il, et suite à l'annonce tonitruante en 1992 (par Al Gore) d'un "trou d'ozone au-dessus de Kennebunkport", l'arrêt de la production des CFC est avancé à 1995 !

Succès total de l'opération "Ozone" : Le fréon est interdit de production, tandis des produits de remplacement, beaucoup plus profitables, sont mis sur le marché. Rowland et Molina obtiendront le prix Nobel de chimie en 1995 pour leur contribution. Mais ce n'est pas le plus important.

Le plus important, c'est que l'écologisme politique vient de remporter une immense victoire, en devenant une force d'influence qui transcende les nations.

Et tout cela, sans que la diminution de la couche à ozone ait jamais été prouvée. Par la suite, on en entendra de moins en moins parler.

Transition : Une sécheresse qui tombe à pic

Après la signature du protocole de Montréal, il va falloir trouver un nouveau thème catastrophiste pour entretenir la dynamique écologiste. Réciproquement, les politiciens ont compris le bénéfice qu'ils peuvent tirer de la récupération du mouvement. En 1988, année d'élections présidentielles, c'est la sécheresse aux Etats-Unis, une sécheresse qui entraîne des pertes énormes dans le secteur de l'agriculture. C'est à cette époque qu'émerge le sénateur Al Gore, opportuniste de l'écologisme, qui va insister sur la sécheresse lors de ses meetings électoraux, et c'est à ce moment-là que le Dr James Hansen, de la NASA, va annoncer au Sénat américain qu'il est sûr à 99% que le "réchauffement global" est arrivé.Cette sécheresse de 1988 aux USA est le point-charnière à partir duquel tout désastre ayant un rapport avec le climat sera imputé à l'effet de serre, causé par l'augmentation de CO2 dans l'atmosphère, causée par l'industrie humaine.

Acte 3 : La genèse de l'Eglise de Climatologie

L'organisation qui avait la responsabilité de faire croire aux gouvernements que la couche à ozone diminuait, l'Ozone Trend Panel (OTP), change son nom en Intergovernmental Panel on Climate Change (IPCC), sous la direction du Dr Robert Watson, et gagne le parrainage de la World Meteorological Association et du United Nations Environment Program.

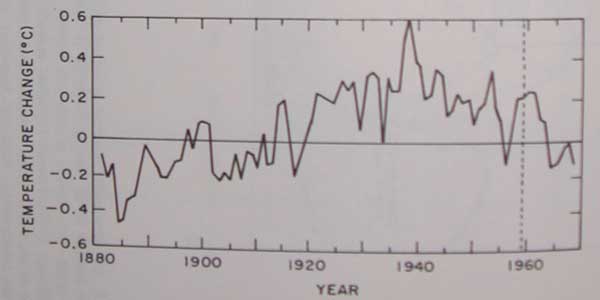

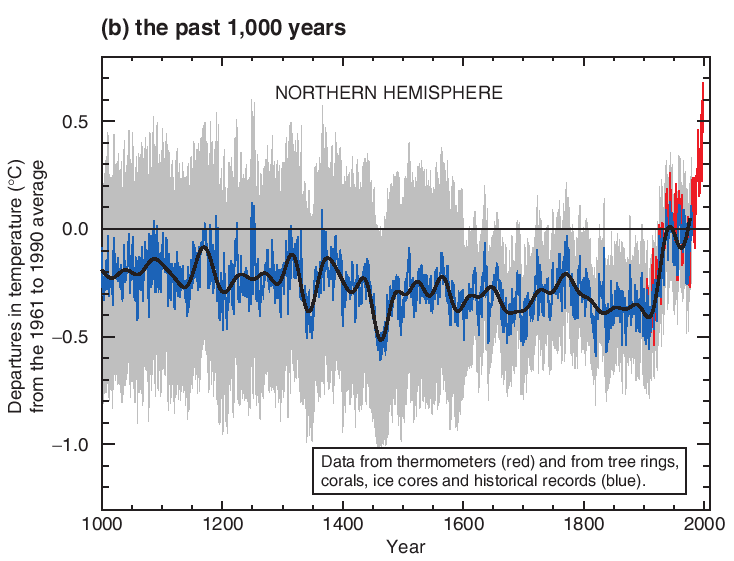

Le premier rapport de l'IPCC (1990), dont la courbe de température est reproduite ci-dessus, fait grande impression au congrès de la United Nations Conference on Environment and Development à Rio de Janeiro en 1992. Mais plus de 3500 scientifiques signataires de l'Appel de Heidelberg signalent leur désaccord avec ce rapport, qui exposait des données sans rapport avec ses conclusions et des méthodes non scientifiques. En clair, ce rapport n'était que de la poudre aux yeux pseudo-scientifique. Toutefois les personnalités politiques présentes à Rio de Janeiro furent convaincues (ou contraintes par la pression des mouvements écologistes de leurs pays) par le "résumé à l'usage des politiciens", et un traité fut signé, appelant à la "stabilisation des concentrations de gaz à effet de serre dans l'atmosphère à un niveau qui préviendrait une interférence humaine dangereuse avec le système climatique".

En 1995, l'IPCC a préparé un nouveau rapport. Les prédictions du premier ne se sont pas réalisées, il ne fait pas assez chaud. Par dessus le marché, le modèle prévoyait que l'atmosphère se réchaufferait, tandis que les mesures indépendantes réalisées par ballons ou par satellites montrent qu'au contraire, l'atmosphère a tendance à se refroidir. Plutôt que de se dire qu'après tout il n'y a peut-être pas de "réchauffement global", on va déduire de cette faillite des modèles qu'il y avait, outre l'effet de serre, un effet de refroidissement surimposé, causé par l'albedo des aérosols introduits par la pollution.

C'est à l'occasion de la publication de ce second rapport que l'IPCC trouve pour son "résumé à l'usage des politiciens" une formule permettant d'ignorer les mesures, qui contredisent les modèles, en les traitant comme un bruit de fond : "Le bilan de preuve suggère une influence humaine discernable sur le climat global". Ce slogan est soigneusement choisi parce qu'on peut l'interpréter de bien des manières, ce qui permet de la latitude quand au "bon" modèle parmi la vingtaine qui sont proposés, tous très différents les uns des autres par leurs prédictions, prévoyant une augmentation de la température d'ici 2100 dans une fourchette de 1°C à 3,5°C (soit plus de 300% de variation !). Finalement, celui qui a la faveur des politiciens est celui qui prévoit une augmentation de 2°C, ce qui coupe la poire en deux et permettra de limiter les dégâts quand on constatera qu'il foire comme les autres.

Le rapport de 1995 permet de focaliser l'attention et de relancer l'inquiétude du public, mais dès 1998, Hansen reconnaît que l'on connaît trop peu les facteurs qui influencent le climat pour prédire les changements futurs. L'hypothèse des aérosols perd de la popularité, les données des stations de surface et les mesures par satellites ne sont toujours pas en accord, ce qui jette le doute, et de plus en plus de scientifiques commencent à soupçonner que le principal facteur de variation du climat serait tout simplement le Soleil. Pour ranimer la foi du public, il va falloir frapper un grand coup.

Acte 4 : Un grand coup de crosse de hockey !

Le grand coup en question vient dans la version 2001 du rapport de l'IPCC, c'est le graphe ci-dessous :

Ce graphe est le clou du rapport, où il apparaît pas moins de 6 fois. Ce n'est pas le genre de graphe auquel on s'attendrait dans une publication climatique, mais plutôt dans une brochure de présentation pour une "opportunité" financière. Il représente une reconstitution de la courbe de température moyenne dans l'hémisphère nord sur les 1000 dernières années. Ce qui frappe au premier abord, c'est la relative stabilité des températures suivie par un accroissement très rapide durant le XXème siècle, ce qui lui donne l'allure générale d'une crosse de hockey, d'où son nom de Hockey stick. Il a été produit par Mann, Bradley et Hugues en 1998, et on appellera cette étude MBH98 dans la suite.

Ce graphe fait sensation, et on le retrouve bientôt quasiment partout, à la une des journaux, sur les brochures écologistes, et on le voit rapidement comme la preuve que la température moyenne s'élève partout dans le monde, comme on peut le constater sur cette brochure de l'USGCRP datant de 2000, où le titre du graphe n'est plus "hémisphère nord", mais "1000 ans de changement global de température et de CO2". Le maître-slogan accompagnant ce graphe : 1990 a été la décennie la plus chaude, et 1998 l'année la plus chaude du millénaire.

Tout petit problème, toutefois : personne n'a reproduit les résultats de MBH98, ni même tenté, semble-t-il. Et c'est gênant, car sur le Hockeystick, la période chaude médiévale et le petit âge glaciaire ont disparu (voir plus haut, ces deux périodes sont clairement visibles sur le graphe du rapport de 1990, mais cela n'a pas été très efficace pour "vendre" le réchauffement), et ce malgré le fait que leur existence est attestée par une énorme masse de documents historiques, et qu'elle a eu lieu partout dans le monde, et pas seulement en Europe, comme d'autres études le confirment indépendamment. Alors comment se fait-il que le Hockeystick, qui semble autant susciter le consensus, ne rende pas compte de ces variations passées ? (et au passage, pourquoi ne semble-t-on pas s'en être ému, à l'IPCC ?)

On remarquera tout d'abord que si la période chaude médiévale avait été conservée, le graphe aurait probablement eu beaucoup moins d'impact, puisque, comme d'une part il faisait plus chaud à l'époque que de nos jours, on ne pourrait plus dire que "1990 a été la décennie la plus chaude du millénaire", et d'autre part, comme il n'y avait pas d'industrie lourde au moyen-âge, il deviendrait illico beaucoup plus difficile d'accuser les dégagements de CO2 industriels. On saura plus tard par David Deming que la consigne avait justement été de se débarrasser de cette période médiévale, façon "trou de mémoire", comme dans 1984 de George Orwell.

Ce qui importe, c'est que c'est grâce à ce curieux graphe que le protocole de Kyoto remporte tant de succès. S'il n'avait pas existé, en effet, peu de nations auraient ressenti assez de motivation pour s'engager à limiter leur développement (pour décider les plus hésitants, toutefois, le protocole de Kyoto contient aussi une carotte financière alléchante dont nous allons reparler plus bas).

Pour ce qui est du graphe lui-même, toutefois, les interrogations qu'il suscite ne peuvent rester éternellement sans réponse : comment a-t-il été composé ? C'est une reconstitution de la courbe de températures de l'hémisphère nord, autrement dit pas une série de mesures directes. Pour tenter de deviner la température qu'il faisait il y a mille ans, les chercheurs essaient de trouver une corrélation entre les températures et des séries de "proxys", c'est à dire de grandeurs telles que les propriétés des couches successives de glaces de banquises, ou les stries d'accroissement des coraux ou des troncs d'arbres (les arbres grossissent plus ou moins vite selon l'importance de plusieurs facteurs, comme les précipitations, le taux de CO2, ou la température).

Dans le cas de MBH98, les proxys les plus importants par leur nombre et leur "poids" dans le calcul sont les troncs d'arbres. Le problème comportant plus d'équations que d'inconnues, la méthode mathématique d'analyse en composants principaux (PCA) est utilisée. Cette méthode largement utilisée permet de remplacer dans le calcul un groupe de séries par une moyenne pondérée (appelée composant principal, ou PC) de ces séries, qui permet autant que possible d'expliquer la variabilité des séries utilisées. Il reste toujours une matrice de résidus non expliqués, mais cette matrice peut aussi être ramenée à un PC, et dans ce cas le PC original est appelé PC1, le second PC2. Le processus peut être poursuivi plus loin, on peut obtenir des PC3, PC4, etc. Toutefois, plus ou progresse dans les PC, moins le PC a d'importance dans le résultat final, ce qui fait que généralement on peut ramener un grand nombre de séries à un petit nombre de PC, le PC1 contenant l'essentiel de l'information, le PC2 beaucoup moins, etc. MBH98 utilise 112 proxys, 71 étant des séries individuelles (dans les faits, un tronc d'arbre coupé sur lequel on a mesuré les stries d'accroissement), et 31 étant des PC construits sur un total de 300 séries réparties sur 6 régions (Amérique du Nord, Mexique Ouest, etc).

En 2003, Stephen McIntyre essaye de reproduire le Hockeystick. Il a besoin des données originales, pour cela, et les demande à l'auteur principal de MBH98, Mann. Ce dernier consent à les lui fournir après quelques réticences. C'est alors que McIntyre découvre que les PC utilisés dans MBH98 ne peuvent être reproduits. Il cherche alors les données originales permettant de les reconstituer, et dans la foulée découvre aussi quelques erreurs (séries obsolètes ou tronquées sans explications, etc), qu'il signale dans un article publié avec Ross McKitrick en 2003, Corrections à la base de données de proxys utilisée par Mann et al pour la température moyenne de l'hémisphère nord (article ci-après référencé comme MM03). Dans cet article, ils signalent que la plupart des erreurs sont sans conséquence sur le résultat final, sauf lorsque l'on remplace les fameux PC impossibles à reproduire...

Mann défend son beefsteak, et répond à MM03 que les données qu'ils ont examinées ne sont pas les bonnes (c'est pourtant lui-même qui les a fournies) et leur donne l'URL d'une archive FTP où se situe les bonnes données. Après examen de ces bonnes données, McIntyre et McKitrick découvrent qu'il s'agit grosso-modo des mêmes données, mais qu'elles différent de ce que Mann et al décrivent dans leur article dans Nature. Après en avoir été informée et avoir constaté de visu les différences, Nature ordonne à Mann et al de publier un Corrigendum, en 2004.

Mann répond aussi à McIntyre et McKitrick qu'ils n'ont pas su répliquer exactement son algorithme de calcul des proxys. Et justement, personne n'y est arrivé. Mann est l'auteur du programme Fortran utilisé dans MBH98, mais refuse de fournir le code source, attitude incompréhensible. Néanmoins, se passant de la collaboration de l'illustre climatologue, McIntyre écrit un programme d'émulation qui permet au moins de se rendre compte que Mann a bricolé des séries en bouchant les vides des unes avec les données des autres. Le cocktail exact reste un mystère.

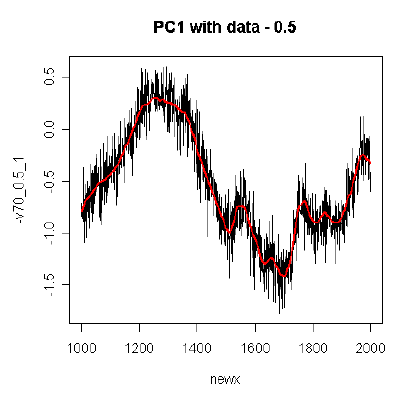

Pour ce qui est des PC irreproductibles, comme McIntyre et McKitrick le découvriront dans le code source caché dans le site FTP de Mann, l'algorithme utilisé consiste à les recentrer autour, non pas de la valeur moyenne de l'intégralité leurs séries, mais autour de la valeur moyenne de la portion correspondant au XXème siècle, ce qui "remonte" de deux bons ordres de grandeur leur poids dans la reconstruction finale, c'est à dire plus de poids que toutes les autres séries réunies ! Leur forme particulière sera donc imposée artificiellement au résultat.

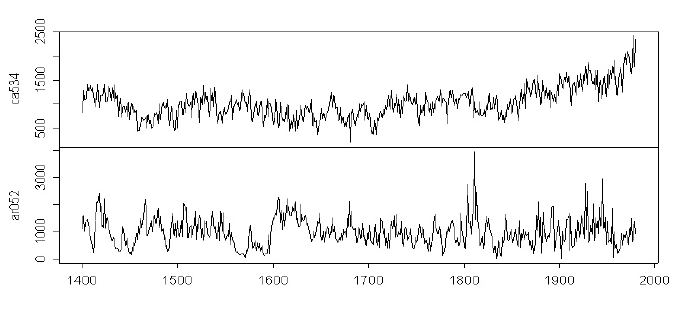

Dans le cas de MBH98, la série dont la forme particulière est ainsi sélectionnée est celle construite à partir des mesures des stries d'accroissement des pins de Bristlecone poussant dans Sheep Valley, en Californie. La série est reproduite ci-dessous, en haut. Cette série, publiée par Graybill et Idso en 1993, a comme particularité d'exhiber une forte croissance, encore non expliquée (les enregistrements de température de Sheep Valley pendant la même période ne correspondent pas), au XXème siècle, qui donne à sa courbe de stries d'accroissement cette forme particulière. En bas, une série sans allure de crosse de hockey, telle que toutes les autres séries de la base de données se présentent généralement :

McIntyre et McKitrick décrivent cette entourloupe hallucinante dans un article qu'ils envoient à Nature. Après 8 mois d'attente, Nature rejette l'article au motif qu'il est trop long et trop technique pour intéresser son lectorat. Ceci n'empêche pas la revue de publier un nouveau Corrigendum de Mann et al., dans un supplément en ligne, dans lequel la fine équipe révèle sa méthode non standard, tout en affirmant qu'elle n'affecte pas le résultat.

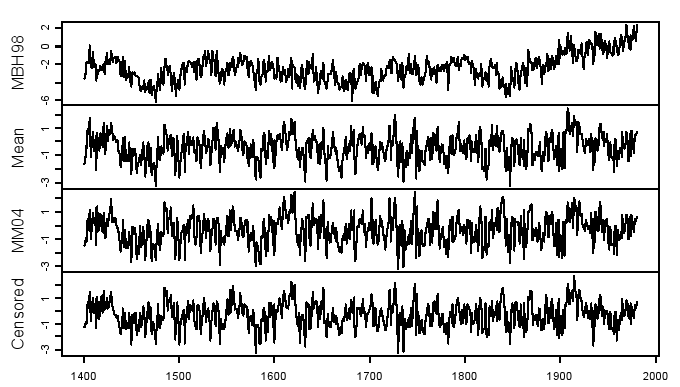

Cette dernière affirmation est d'autant plus curieuse que McIntyre et McKitrick ont découvert un dossier intitulé CENSORED dans le site FTP de Mann, dossier contenant des données qui se révèlent être le résultat des calculs de Mann, une fois retirées les séries de Graybill-Idso. Ce qui permet la comparaison suivante :

Le graphe du cadre du haut sort de MBH98, les trois suivants sont successivement produits par une moyenne simple des proxys, un calcul (réalisé par McIntyre et McKitrick en 2004) par la méthode PCA standard, sans pré-augmenter le dernier siècle des séries, et enfin le calcul censuré par Mann. Inutile de gamberger longtemps pour se rendre compte de la raison pour laquelle Mann a censuré ce résultat...

Acte 5 : Le retour de bâton

Dès la parution de son deuxième Corrigendum dans Nature, Mann claironne sur son site (RealClimate, créé par Gavin Schmidt pour contrebalancer l'influence croissante du site sceptique Climate Audit) que les calculs de McIntyre et McKitrick sont "discrédités" par d'autres études. Mann jouissant d'une grande influence via son blog, beaucoup de visiteurs inattentifs le croient sur parole. Mais pas Edward Wegman, directeur du Comité de Statistiques Théoriques et Appliquées de l'Académie des Sciences US. Celui-ci va constituer un panel de statisticiens qui vont étudier la méthode de Mann et publier le Rapport Wegman qui fera l'objet d'une présentation au Congrès américain, et suscitera questions et réponses en juillet 2006.Deux points principaux émergeront du rapport Wegman. En premier lieu, les analyses et conclusions de McIntyre et McKitrick seront confirmées, et ce de façon plutôt humoristique : les statisticiens vont s'amuser à appliquer la méthode de Mann, mais au lieu d'utiliser les séries des pins de Bristlecone, ils vont injecter la courbe de température du rapport de l'IPCC paru en 1990. Et naturellement...

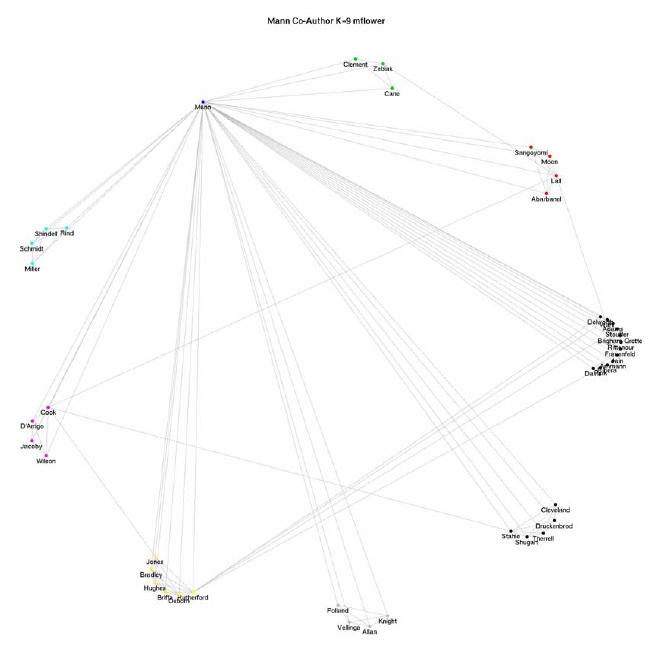

C'est un clou de plus dans le cercueil du Hockeystick, et en fait ce graphe, qui était la bannière des chantres du Réchauffement global, est alors tellement discrédité qu'on n'ose plus trop le sortir. Mais le rapport Wegman va plus loin, il cherche à cerner les causes du "consensus" qui protégeait cette entourloupe de la critique. En effet, on attend du processus de Peer review (revue par les pairs) qui est caractéristique des publications scientifiques que ce genre d'errement soit filtré à la source, et en un mot, l'étude MBH98 n'aurait jamais dû être publiée, si le système fonctionnait (ou alors comme exemple de démarche à éviter).

L'étude du groupe de Wegman comporte donc une partie intitulée "Analyse du réseau de relations dans le milieu des auteurs de publications ayant trait aux reconstructions de températures". On va y trouver une dissection des liens qui font de Mann un élément central de cette nébuleuse, illustrée par des graphes explicites, comme celui-ci :

L'analyse des relations de Mann indique que les différentes études publiées sur le sujet ne sont probablement pas si indépendantes que l'on aimerait le croire, et en effet, le groupe de Wegman s'aperçoit que les mêmes séries de proxy sont très souvent réutilisées, ce qui naturellement introduit une grande similarité dans les résultats et les conclusions, qui ne peuvent pas prétendre à être des "vérifications indépendantes".

En bref, le rapport Wegman identifie une clique de chercheurs en paléoclimatologie, qui se serrent les coudes, quitte à soutenir des études erronées contre les critiques, même quand les études erronées en question sont à la base de décisions de politique internationale ayant des conséquences sur des milliards de gens. De même, l'existence de cette clique implique que, lors du processus de Peer review, les articles n'allant pas dans le sens du Hockeystick ont plus de chances d'être rejetés avant publication... ironiquement, on peut remarquer un effet de feedback climatique, dans les publications climatiques.

Entre autres, le rapport recommande de mettre en place des procédures d'audit des études climatiques par des chercheurs indépendants et des statisticiens de métier.

Acte 6 : Un plat de spaghetti qui sent le réchauffé

Fin 2006, donc, la côte de popularité du Hockeystick est tellement basse que même les climatologues "sérieux" vont s'engouffrer dans cette opportunité de faire parler d'eux. En mai 2007, Hans von Storch et Eduardo Zorita postent sur le blog de Nature un résumé de l'affaire, arrangé de sorte à suggérer que le mérite leur revient, ce qui leur attire les foudres des commentateurs, mais permet aussi de mesurer à quel point ce graphe est passé de mode.On devrait donc s'attendre à ce que, pour le quatrième rapport de l'IPCC, paru trois mois après son "résumé pour policiticiens" (si, si !), le Hockeystick soit passé à la trappe, n'est-ce pas ? C'est ce que nous allons voir...

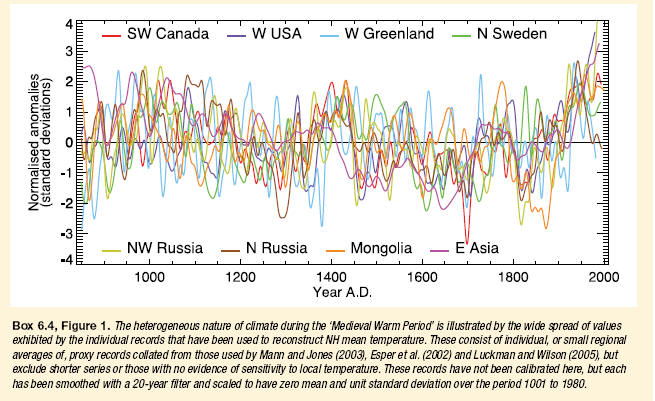

Pour cette nouvelle mouture du rapport de l'IPCC, l'auteur principal de la section "Paléoclimatologie" est Briffa, qui, comme Mann, use de sa position pour faire publier son travail dans le rapport. Son objectif principal est toujours d'éliminer la période chaude médiévale, et de conserver la forme en crosse de hockey, essentielle au discours alarmiste. La version du jour du graphe de température (au passage, on notera qu'il ne s'agit encore et toujours que de l'hémisphère nord) fait appel à un mélange de différentes reconstructions lissées et plaquées toutes ensemble sur la même grille, pour faire plus d'effet. Le plat de spaghetti résultant (page 468) est celui-ci :

Surprise, le hockeystick de Mann (renommé "W USA") s'y trouve encore. C'est la courbe bleue qui part en chandelle sur la droite du graphe. L'autre courbe qui s'envole, intitulée "NW Russia", provient d'une étude de Briffa et Osborn publiée en 2006 et basée sur les séries de Yamal, des séries anormales caractérisées par une forte croissance au XXème siècle. Voilà pour l'effet "crosse de hockey", qui disparaît complètement lorsqu'on soustrait ces deux courbes-ci :

McIntyre remarque aussi que deux courbes caractérisées par une nette baisse lors du XXème siècle ont été discrètement éliminées de la version finale du rapport. Si Briffa avait voulu éviter de trop "noyer" le Hockeystick, il ne s'y serait pas pris autrement.

Mais la véritable raison d'être de ce graphe n'est pas de répéter le coup du Hockeystick, car pour cela il suffit de réutiliser le graphe du rapport précédent tout en prétendant ignorer qu'il a été discrédité... la véritable raison, comme le suggère la légende qui associe les courbes à des régions géographiques et non à des études, est d'imposer l'idée que la période chaude médiévale n'était qu'un évènement localisé. En effet, on voit sans mal que toutes ces reconstructions se contredisent les unes les autres, quand l'une dit "chaud", une autre dit "froid", et ceci sur tout l'intervalle. Dans cette bouillabaisse, bien malin qui peut discerner une quelconque tendance générale, ce qui permet de dire au lecteur inattentif "Vous voyez, la période chaude médiévale n'a pas existé !", et ceci au mépris de ce qu'on sait déjà sur le sujet (voir plus haut), car il est essentiel de perpétuer l'idée qu'il n'a jamais fait aussi chaud qu'à l'époque actuelle. Tout le discours alarmiste est basé sur cette notion.

Ironiquement, conséquence probablement inattendue, ce plat de spaghetti fait la démonstration claire que l'étude des stries d'accroissement des arbres n'a que très peu, sinon aucune valeur probante pour ce qui est de la reconstitution des températures passées.

Acte 7 : Un nouvel impôt et une martingale très juteuse...

Les états signataires des accords de Kyoto s'engagent à faire en sorte de réduire la production de CO2 (supposé être la cause du "réchauffement global" que le Hockeystick est censé montrer) de leur industrie, ce qui en pratique les contraint à mettre en place un système de limitation qui oblige les entreprises dépassant une limite d'"émission"donnée à acheter des crédits Carbone à d'autres entreprises, qui ont atteint et dépassé leur propre quota de limitation ou bien qui par exemple planteront des arbres, ou exerceront tout autre moyen censé retirer de l'atmosphère autant de CO2 que la première entreprise est supposée y introduire.On notera que ceci est, sous un autre nom, un impôt sur la pollution (à un détail près : le gaz carbonique n'est pas un polluant, mais ceci est une autre discussion), un impôt que les écologistes avaient toujours rêvé d'instituer, car il pénalise l'activité industrielle. Cela ne peut pas aller sans un effet de domino qui, au final, pourrait avoir des conséquences fâcheuses sur l'économie des pays. Mais pour arriver à le faire accepter, il fallait bien que les victimes y trouvassent leur compte. C'est là qu'une catégorie d'intermédiaires essentielle entre en jeu : les financiers.

Paradoxalement, c'est aux USA, pays qui a refusé de signer les accords de Kyoto, que le premier marché d'échange des "crédits Carbone" voit le jour. Le 12 décembre 2003, en effet, Richard Sandor, un trader spécialisé dans les futures (contrats financiers dans lesquels les acheteurs se donnent l'obligation d'acheter une marchandise à une date future prédeterminée), ouvre le Chicago Climate Exchange (CCX). Sandor est un vieux briscard de la finance, extrêmement intelligent et créatif, il a par exemple réussi à créer des futures sur les tremblements de terre. Chapeau.

Quelle est la fonction de cet échange ? Les membres s'engagent par contrat à réduire leurs émissions de CO2 de 1% (ou plus) par an, un objectif qui une fois atteint leur donne un "crédit" qu'ils peuvent revendre à un autre membre dont le quota de réduction n'est pas atteint. Réciproquement, un membre qui désire augmenter son "quota" achète des "crédits" aux autres membres, ce qui lui fait un offset qu'il peut soustraire au chiffre de ses émissions. La clé de voûte de ce système est le contrat que signent tous les membres, qui devient une obligation légale (et qui fonctionne donc même en l'absence de législation spécifique, comme aux Etats-Unis). Les membres ne sont pas tous, loin de là, des entreprises qui produisent du CO2 ou qui plantent des arbres. La plupart des membres sont une nouvelle race d'intermédiaires, les aggrégateurs d'offsets, les fournisseurs d'offsets, ainsi que les fournisseurs de liquidité, qui maintiennent une liste de clients émetteurs de CO2 et une liste de clients dont le quota de réduction est atteint et dépassé, et qui peuvent revendre leur offset aux premiers.

A titre anecdotique, on compte, parmi les membres du CCX, Generation Investment Management LLP, un fonds de placement créé en avril 2004, dont le chairman n'est autre que Al Gore, ce même Al Gore qui crie sur les toits qu'il achète des "crédits Carbone" à chaque fois qu'il prend l'avion. On aura deviné à qui il "achète" ses crédits. Voilà un entrepreneur qui sait comment multiplier ses revenus, tout en soignant son image de marque et en augmentant ses chances d'accèder à la présidence US à son prochain essai...

Acheter et revendre des nombres sortant d'une métrique quelconque, comme ici le dégagement de CO2, permet de générer des commissions, ce qui ouvre des perspectives alléchantes... Le monde financier sait reconnaître une opportunité quand elle se présente, comme quantité de publications au sujet de cette nouvelle manne potentielle en font foi. On estime à plusieurs dizaines, voire centaines de milliards de dollars le volume de ce marché, dans les prochaines années. Les plus grandes banques d'investissement, comme Goldman Sachs, ont déjà investi des milliards. Comment resister ?

Le marché semblant prometteur, en 2005, la société de Sandor, Climate Exchange PLC, lance une filiale du CCX en Europe, l'European Climate Exchange (ECX). Pour que le marché des "émissions" puisse passer à la vitesse supérieure, en effet, sa globalisation est nécessaire, tout comme est nécessaire l'entrée de l'Europe dans ce jeu international.

En mars 2007, alors que l'encre du nouveau rapport de l'IPCC n'est pas encore sèche, Al Gore, nommé en octobre 2006 "conseiller spécial pour le changement climatique" du gouvernement anglais, adresse le Sommet Européen sur l'Energie à Bruxelles. On exige des gouvernements européens qu'ils s'engagent à des réductions d'émissions de CO2 de 20% à 30% d'ici à 2020. L'objectif est, pour beaucoup, irréaliste, et l'on entend les dents grincer. Les mauvaises langues diront que l'on assiste à une réédition du coup de l'arrêt de la production des CFC, deux décennies plus tôt...

D'un côté, nous avons donc une nouvelle bulle financière, celle du marché des "émissions", qui s'annonce, et de l'autre nous avons des objectifs qui impliquent la création d'une sorte de gouvernement mondial. Le problème est que, comme lors de l'affaire de l'ozone, tout ceci ne repose sur rien de concret. Les impératifs politiques imposent une conclusion pré-établie à la recherche scientifique, dont le prestige en sortira fatalement amoindri, et les intérêts en jeu sont tellement énormes que personne n'a vraiment envie de mettre fin à l'opération.

Pourtant, il faudra bien que cela arrive un jour ou l'autre ; il suffira de quelques hivers rigoureux et quelques étés un peu frais dans l'hémisphère nord, par exemple, ou bien d'un ras-le-bol de l'industrie face à des quotas de réductions d'"émissions" irréalistes... En attendant, une décennie pourrait bien s'écouler, alors pourquoi ne pas faire comme tout le monde et en profiter bien hypocritement ?

Réagissez à ce dossier dans son forum en ligne associé